Azure Stream Analytics 作业和 Visual Studio 工具

5.00/5 (1投票)

如果有一个工具可以帮助你在 Visual Studio 中创建流解决方案,这样你就不必通过浏览器并进行一些手动按钮点击操作,那会怎么样? 这就是 Azure Data Lake 和 Stream Analytics 工具扩展发挥作用的地方。

引言

创建 Azure 流分析作业并使用它们总是很有趣。 如果有一个工具可以帮助你在 Visual Studio 中创建流解决方案,这样你就不必通过浏览器并进行一些手动按钮点击操作,那会怎么样? 这就是 Azure Data Lake 和 Stream Analytics 工具扩展发挥作用的地方。 在我之前的文章中,我们已经讨论了 什么是 Azure 流分析作业以及我们如何使用它,如果你还没有阅读过,请阅读一下。 现在让我们去使用这个扩展。

背景

最近,我开始使用 Azure IoT 设备工具包,这是一个很棒的微控制器板,它可以将大量信息(如温度、湿度)发送到 Azure 云,因为它有很多内置传感器。 现在,在本文中,我们将为我们的流分析作业创建一个 Visual Studio 解决方案,以便可以将该解决方案移动到源代码管理并易于管理。

请注意,我们要使用的扩展尚不受 Visual Studio 2019 支持,如果你尝试在 VS2019 中创建它,你将收到一个错误,如 Visual Studio 的版本不受支持。

该扩展在 VS2019 中不受支持。

环境设置

我假设你有一个有效的 Azure 订阅并且你有权在其中创建资源。

使用所需的工作负载修改 Visual Studio

现在让我们转到 Visual Studio 安装程序并修改工作负载。

修改工作负载后,请确保该扩展在你的扩展中可用,你可以通过转到 工具 -> 扩展菜单 来实现。

创建新的流分析项目

启用扩展后,你应该能够创建一个新的 Azure 流分析应用程序。

新项目将包含以下文件

- Input.json

- Output.json

- JobConfig.json

- Script.asaql

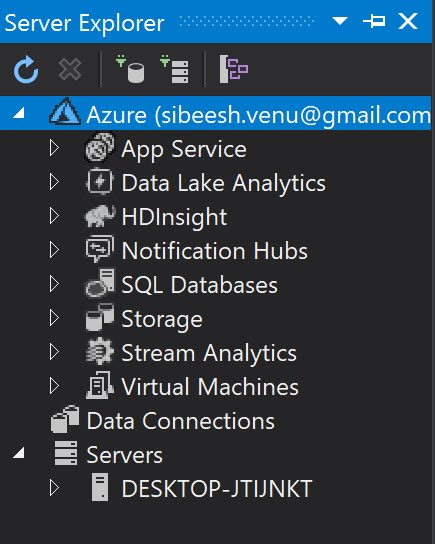

要配置你的订阅,请确保你已在服务器资源管理器中添加了你的订阅。

Input.json 文件是你输入作业拓扑的副本,双击该文件将为你提供配置页面以配置详细信息。

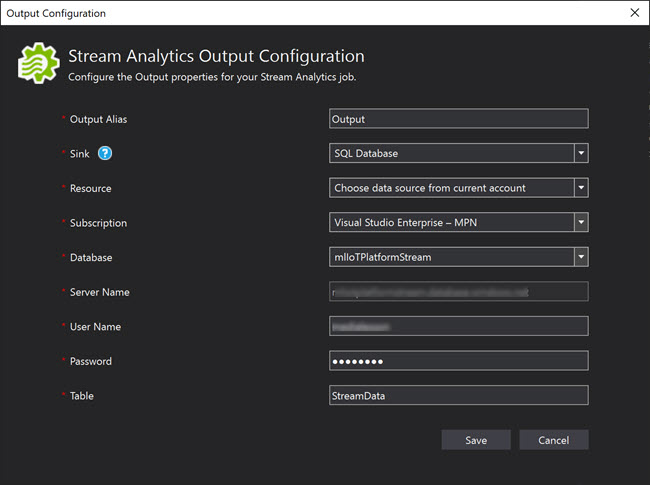

Output.json 文件是你的输出作业拓扑,你可以根据需要拥有任意数量的输出。 在我的例子中,只有一个,SQL Server 数据库。

你始终可以使用 JobConfig.json 文件配置你的作业。 当你配置 Job 时,你需要确定你提供的值以及它们的需求是什么。

数据区域设置是你的区域设置输入。 选项输出错误处理用于处理事件无法写入输出的情况,你可以选择“丢弃”或“重试”。 延迟到达容忍窗口是你可以等待事件到达 IoT 中枢的时间范围,时间差是事件时间戳和系统时间之间的时间差。

Script.asaql 文件是你需要添加自定义查询的文件,该查询从输入获取数据并将其发送到输出。

SELECT

messageId,

deviceId,

temperature,

humidity,

pressure,

pointInfo,

IoTHub,

EventEnqueuedUtcTime,

EventProcessedUtcTime,

PartitionId

INTO

streamoutputs

FROM

streaminputs

完成所有操作后,你就可以将它提交到 Azure。 你可以创建一个新作业或使用现有的作业。

提交时,你可以看到一个新的流分析视图将被打开,并且该作业将自动启动。 你始终可以通过转到云资源管理器来查看在你的容器下创建的 blob。

现在只需右键单击你的解决方案并选择“将解决方案添加到源代码管理”,然后将其推送到你的 git 存储库。 将解决方案添加到源代码管理后,你的团队成员可以轻松地更新输入和输出配置并拥有相同的历史记录。

结论

在本文中,我们学习了如何

- 设置 Visual Studio 以使用 Data Lake 和 Stream Analytics 工具

- 使用 Data Lake 和 Stream Analytics 工具

- 配置流分析的输入

- 配置流分析作业

- 在另一个解决方案中使用创建的包

现在轮到你了。你有什么想法?

非常感谢你的阅读。 我很快会回来发布关于同一主题的另一篇文章。 我错过了你认为需要的东西吗? 你觉得这篇文章有用吗? 请不要忘记分享你的反馈。